«Вандализм» учинила парочка предпенсионного возраста, посещавшая Дворец Маффеи в Вероне. Разбираемся, как им удалось сломать часть экспозиции.

«Вандализм» учинила парочка предпенсионного возраста, посещавшая Дворец Маффеи в Вероне. Разбираемся, как им удалось сломать часть экспозиции.

Даже мэр покрасил лицо в синий цвет.

Ей хотелось оставить след в истории.

В Турции, недалеко от Стамбула, бездомная собака самостоятельно принесла своего умирающего щенка в ветеринарную клинику.

Инсайдер Сонни Диксон поделился в своём личном блоге фотографиями, на которых, предположительно, запечатлены прототипы нового iPhone 16 во всех…

Пользователь сайта Reddit опубликовал в своем аккаунте редкую фотографию iPhon’а. Снимок примечателен тем, что на смартфоне нет ни одной камеры.

Супруги из штата Мичиган, Хейли и Тревор Гилмартин, сделали неожиданное открытие во время ремонта своего дома на берегу озера Гурон. Избавившись от…

32-летняя Сара Тейлор из Беркшира каждую ночь ложится спать с тревогой. Вместо спокойного отдыха ее преследует лунатизм – расстройство, превращающее…

В американском штате Небраска произошел невероятный случай: 74-летняя женщина, признанная мертвой, пришла в себя в похоронном бюро.

Малкольм Коллинз, лидер движения «пронаталистов», пропагандирующего многодетность как решение демографической проблемы и пользующегося поддержкой…

На прошлой неделе Google запустил поисковую систему с использованием искусственного интеллекта, и пользователи тут же обнаружили ряд неточностей в…

Жительница Японии, которая является хозяйкой ставшей знаменитой в интернете собаки породы сиба-ину Кабосу, сообщила о смерти своего питомца.

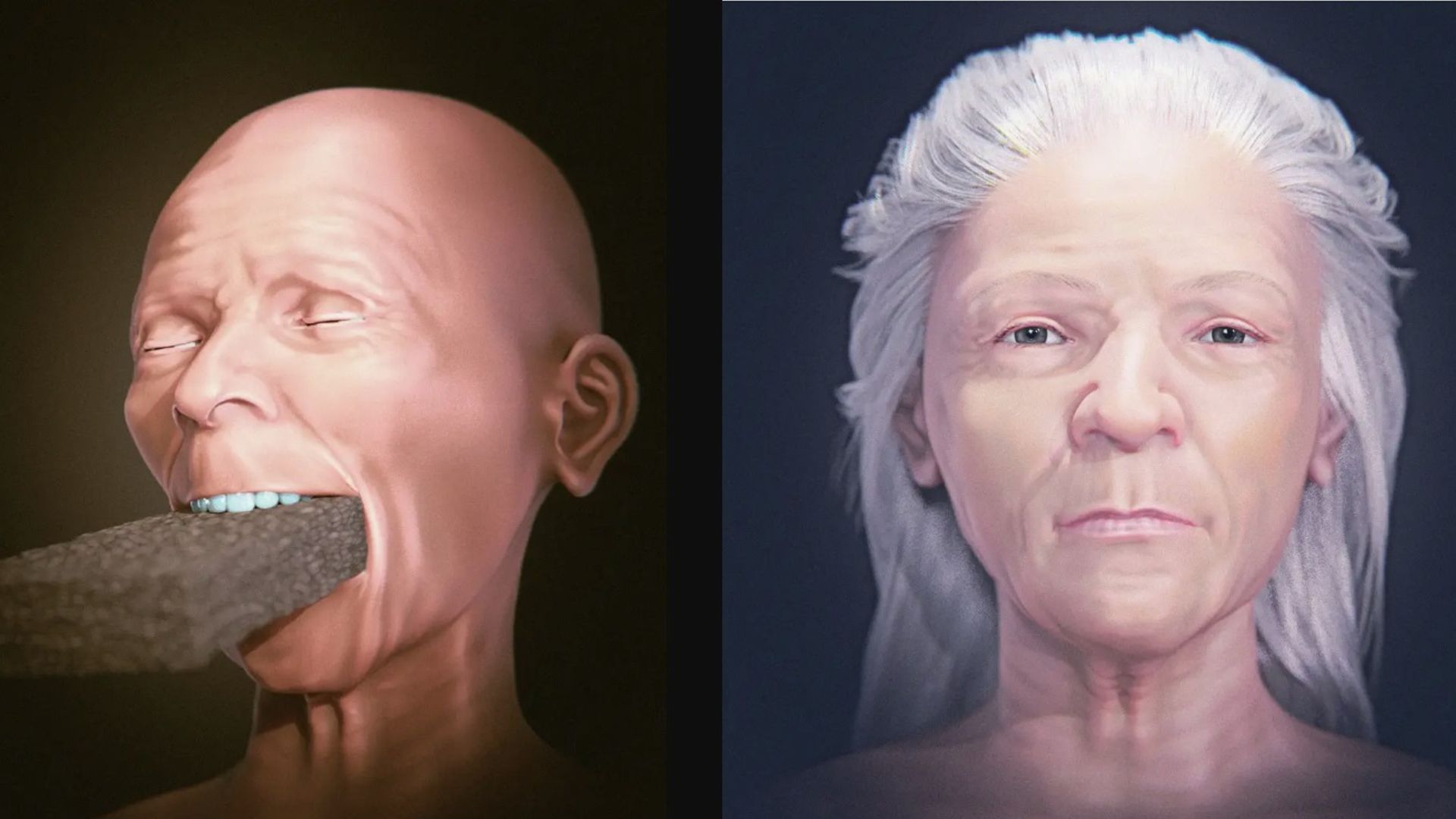

Британские исследователи из Кембриджа воссоздали внешность женщины, жившей в эпоху неандертальцев около 75 тысяч лет назад. Останки ее черепа были…

Не стоит жаловаться, что у вас маленькая квартира, пока не узнаете о жительнице Нью-Йорка по имени Элли. У неё так мало квадратных метров, что…

В Южной Корее страус по кличке Тадори решил повторить авантюру героев мультфильма «Мадагаскар». Он дал дёру из зоопарка и использовал свой статус…

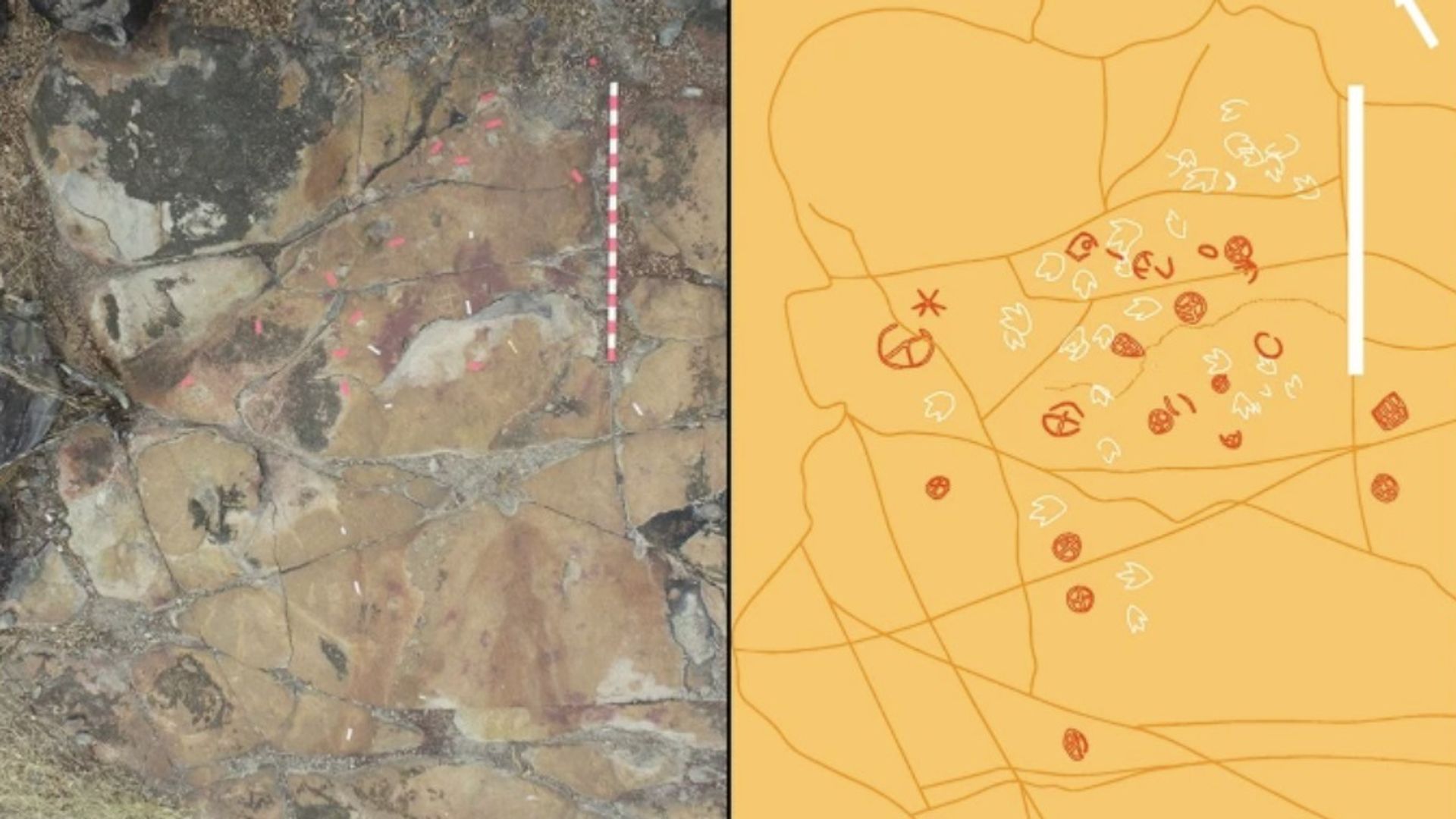

Любопытное открытие учёных на северо-востоке Бразилии: в местечке Серроте-ду-Летрейру (штат Параиба) обнаружены наскальные рисунки древних людей,…

Космический телескоп «Хаббл» снял потрясающий кадр рождения новой звезды. Не на российской эстраде, разумеется, а в системе FS Tau (в районе…

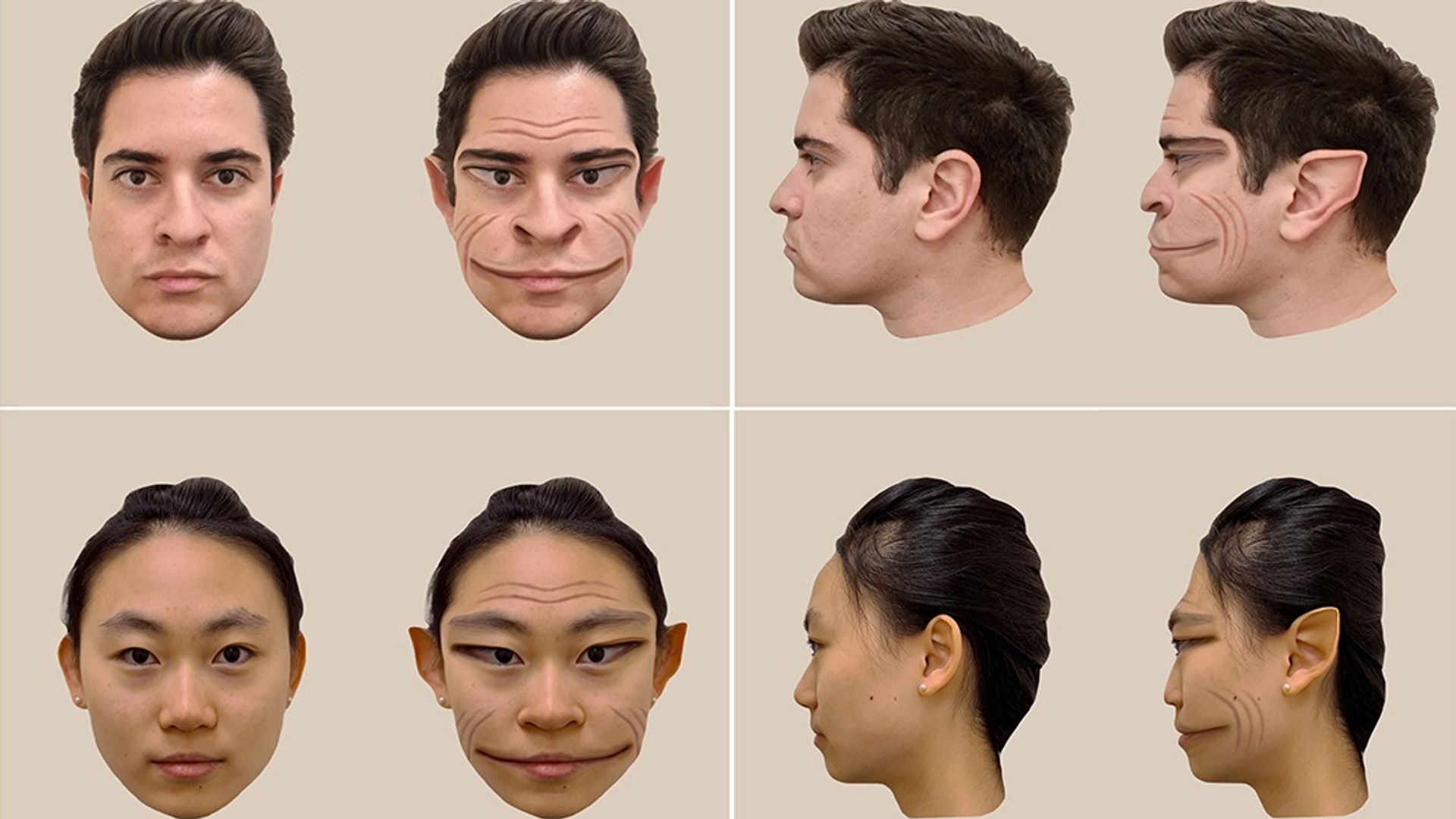

59-летний дальнобойщик из Теннеси по имени Виктор Шарра прославился своим необычным заболеванием. Уже три года он видит окружающих людей с…

Группа учёных исследовала, насколько генетическая предрасположенность влияет на реальные способности человека. Кому суждено родиться гением, а кому –…

Бельгийские учёные разработали нейросеть, которая выведет формулу идеально пива. Для этого в умную программу загрузили тысячи отзывов экспертов и…

С любовью к животным тоже можно переборщить. В британском Чешире пожилая женщина привезла к ветеринару неподвижного ёжика, которого нашла у дороги.…

Учёные, исследовавшие массовое захоронение XVI века на венецианском острове Лазаретто-Нуово, сделали пугающее открытие. Среди останков в братской…

Учёные Лондонского музея естественной истории отправились в центральную часть Тихого океана, чтобы исследовать зону под названием Кларион-Клиппертон.…

Американская сеть тренажёрных залов Planet Fitness резко упала по стоимости акций из-за скандального случая в одном из своих клубов на Аляске.…

Индийский праздник слонов пурам в этом году закончился жестоким конфликтом. Причём повздорили виновники торжества. Два слова в праздничных нарядах и…

Компания OpenAI, создающая искусственные интеллекты, отправила своих представителей в Голливуд, чтобы встретиться с руководителями киностудий и…

Учёные Датского технологического университета (DTU) поделились успехами в разработке нового типа искусственного интеллекта. Он сможет предсказывать…

Забавное ограбление произошло в австралийском Мельбурне. Около 3 часов ночи одетая во всё чёрное женщина проникла в местную пекарню и стащила оттуда…

Жительница канадского Торонто оказалась в неловкой ситуации. Приведя ребёнка в школу, она получила замечание от учительницы. Педагог долго…

В сети обсуждают новое видео с призраком. Оно было снято в Аргентине в начале марта. Люди, которым удалось поймать в кадр таинственную фигуру, далеко…